Çocuk güvenliği, özellikle çocuk cinsel istismarı materyallerinin (CSAM) dolaşımını önlemek söz konusu olduğunda, teknoloji endüstrisinde her zaman kritik bir endişe kaynağı olmuştur. Apple'ın bu konuyu cihazda ele alma girişimleri ve iCloud CSAM algılama araçları ilk duyurulduğunda tartışmalı bir dönüş yaptı.

Apple'ın Aralık 2022'de CSAM algılama araçlarını terk etme kararı soruları gündeme getirdi ve Heat Girişimi adlı bir çocuk güvenlik grubu, Apple'ı cevaplar için itmenin ön saflarında yer aldı. Yanıt olarak, teknoloji devi, CSAM algılama planlarının terk edilmesi için henüz en ayrıntılı açıklamasını sağlamıştır.

Apple çocuk güvenliği ve kullanıcı gizliliği için CSAM tespitini reddetti

Çocuk cinsel istismarı materyali, proaktif çözümler gerektiren derinden rahatsız edici bir sorun olmaya devam etmektedir. Apple başlangıçta bu zararlı içeriğin yayılmasıyla mücadele etmek için CSAM algılama araçları kavramını tanıttı. Ancak şirket, kullanıcı gizliliği ve güvenlik konusunda önemli miktarda geri tepme ve etik endişelerle karşılaştı. Bu tartışmanın ardından, Heat Girişimi Apple'ın kararına karşı güçlü bir duruş aldı ve buna karşı bir kampanya düzenlemekle tehdit etti.

Heat girişimine kapsamlı bir yanıtta (aracılığıylaKablolu), Apple'ın kullanıcı gizliliği ve çocuk güvenliği direktörü Erik Neuenschwander, CSAM tespitinden vazgeçme kararının hafife alınmadığını vurguladı. Şirketin, iletişim güvenliği olarak bilinen bir özellik setine doğru pivotun arkasındaki itici güç olarak tüketici güvenliği ve mahremiyetine olan bağlılığını özetledi. Neuenschwander, CSAM tespiti için şifreli bilgilere erişmeye çalışmanın, Apple'ın çeşitli hükümet talepleriyle çelişen daha geniş gizlilik ve güvenlik ilkeleriyle çelişeceğini açıkladı.

Apple'ın yanıtı, kullanıcı gizliliğinden ve güvenliğinden ödün vermeye karşı değişmez tutumunu vurguladı. Neuenschwander, özel olarak depolanan iCloud verilerinin yaygın olarak taranmasının potansiyel veri ihlalleri için yeni güvenlik açıkları getireceğine dikkat çekti. Dahası, toplu gözetim ve istenmeyen sonuçlara yol açabilecek tehlikeli bir emsal oluşturacak ve Apple'ın övüldüğü temel ilkeleri aşındıracak.

Neuenschwander'ın tepkisi, Apple'ın CSAM tespitini terk etme kararında hayal kırıklığını ifade eden Heat girişiminin lideri Sarah Gardner'a doğrudan hitap etti. Gardner, önerilen çözümün Apple'ı ICloud'dan önemli miktarda CSAM'ı ortadan kaldırırken kullanıcı gizliliğinde lider olarak konumlandıracağına inanıyordu. Mesajında, çocuk cinsel istismarıyla mücadele etmek için kritik teknolojinin uygulanmasının aciliyetini aktardı.

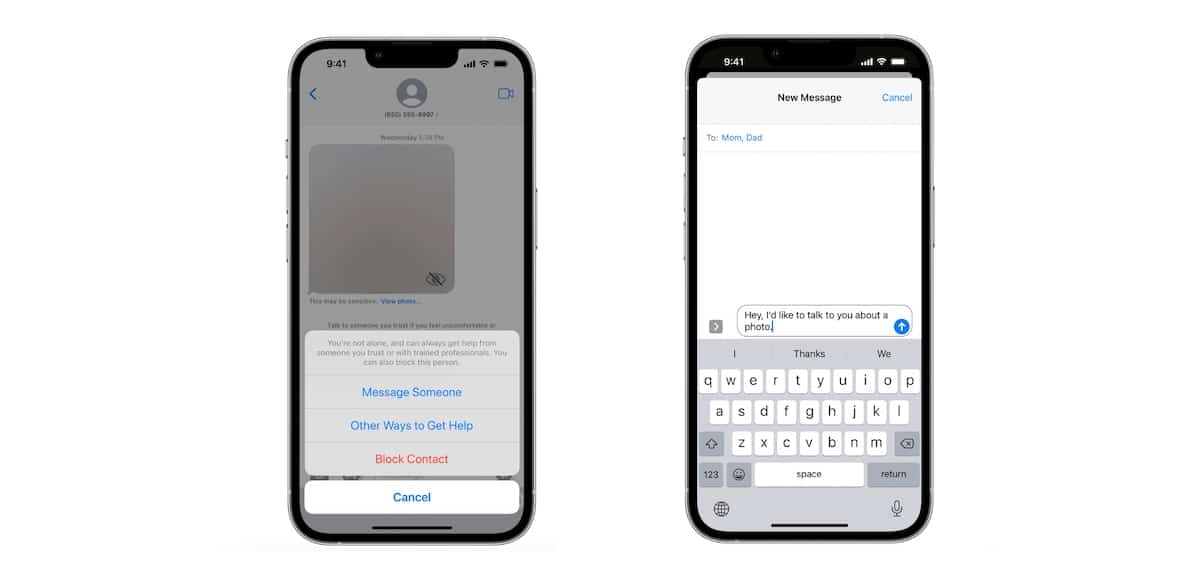

Apple'ın yaklaşımı, raporları işlemek için bir aracı olarak hareket etmek yerine, kurbanları uygun kaynaklara ve kolluk kuvvetlerine yönlendirmeye odaklanmaktadır. Şirket, üçüncü taraf uygulamalarının kullanıcıları eğitmek ve suçluların raporlanmasını kolaylaştırmak için kullanabileceği API'leri geliştiriyor. Apple ayrıca, kullanıcıların mesajlarından açık içeriği filtrelemesine yardımcı olan iletişim güvenliği özelliğini de tanıttı. Bu özellik başlangıçta çocuk hesapları için mevcut olsa da, gelecekte daha fazla genişleme planları ile iOS 17'deki yetişkinlere genişleyecek.

Apple'ın CSAM tespitine devam etmeme kararının, şirketin kullanıcı gizliliği ve güvenliğine yönelik inatçı taahhüdünden kaynaklandığını belirtmek gerekir. Heat girişimine verilen yanıt, bu önemli karara yol açan endişeleri ve düşünceleri açıklığa kavuşturmaktadır. Çocuk cinsel istismarını ele almak çok önemli bir konu olmaya devam ederken, Apple'ın yaklaşımı kullanıcı verilerini korumak ve CSAM'a karşı mücadeleye yardımcı olmak arasında bir denge kurmayı amaçlamaktadır.