İnternete ihtiyaç duymadan Mac'inizde yerel olarak chatgpt gibi bir şey çalıştırıp çalışmadığınızı hiç merak ettiniz mi? Biraz kurulumla, aslında yapabilirsiniz. Bu da ücretsiz. Sohbetlerinizi özel tutmak ister sadece AI'ya çevrimdışı erişim isteyin, burada Mac'inizde yerel olarak güçlü büyük dil modellerini nasıl çalıştırabilirsiniz.

#image_title

Bir Mac'te yerel olarak bir LLM çalıştırmak için neye ihtiyacınız var?

Dalış yapmadan ve kurulumu kontrol etmeden önce, ihtiyacınız olan şey:

Ücretsiz bir araç kullanacağızOllama, LLMS'yi yerel olarak sadece birkaç komutla indirmenize ve çalıştırmanıza olanak tanır. İşte nasıl başlayacağınız:

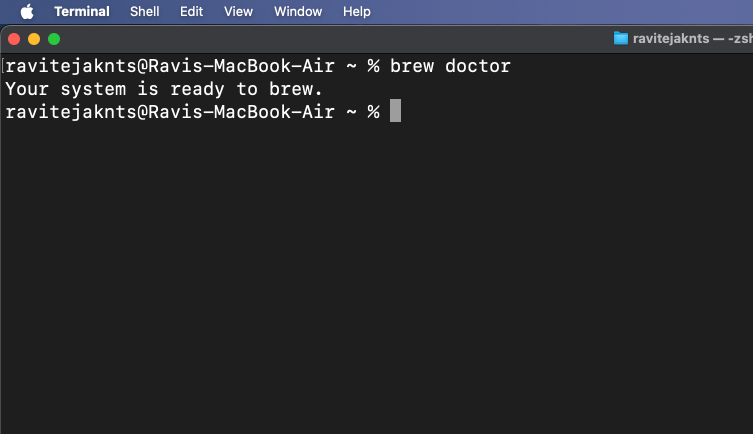

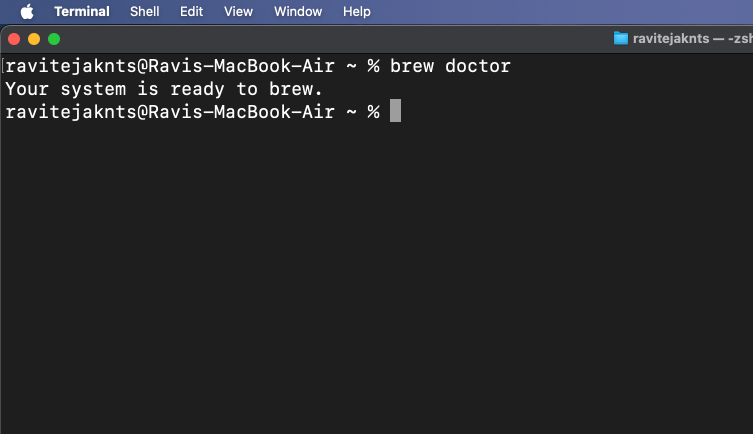

Adım 1: Homebrew'u yükleyin (zaten yüklüse atla)

Homebrew, MacOS için Terminal uygulamasından uygulamaları yüklemenize yardımcı olan bir paket yöneticisidir. Mac'inize zaten homebrew yüklüyseniz, bu adımı atlayabilirsiniz. Ama eğer yapmazsanız, işte nasıl yükleyebilirsiniz:

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"brew doctor

“Sisteminiz demlemeye hazır” görürseniz, gitmekte fayda var.

Herhangi bir sorun yaşıyorsanız veya daha ayrıntılı bir adım adım işlem istiyorsanız, Homebrew'un bir Mac'e nasıl kurulacağına dair kılavuzumuza göz atın.

2. Adım: Ollama'yı kurun ve çalıştırın

Artık Homebrew yüklü ve Mac'inizde kullanıma hazır olduğundan, ollama yükleyelim:

brew install ollamaollama serve

Bu pencereyi açık bırakın veya en aza indirin. Bu komut Ollama'nın arka planda çalışmasını sağlar.

Alternatif olarak,Ollama uygulamasıve herhangi bir normal Mac uygulaması gibi yükleyin. Yapıldıktan sonra uygulamayı açın ve arka planda çalışmaya devam edin.

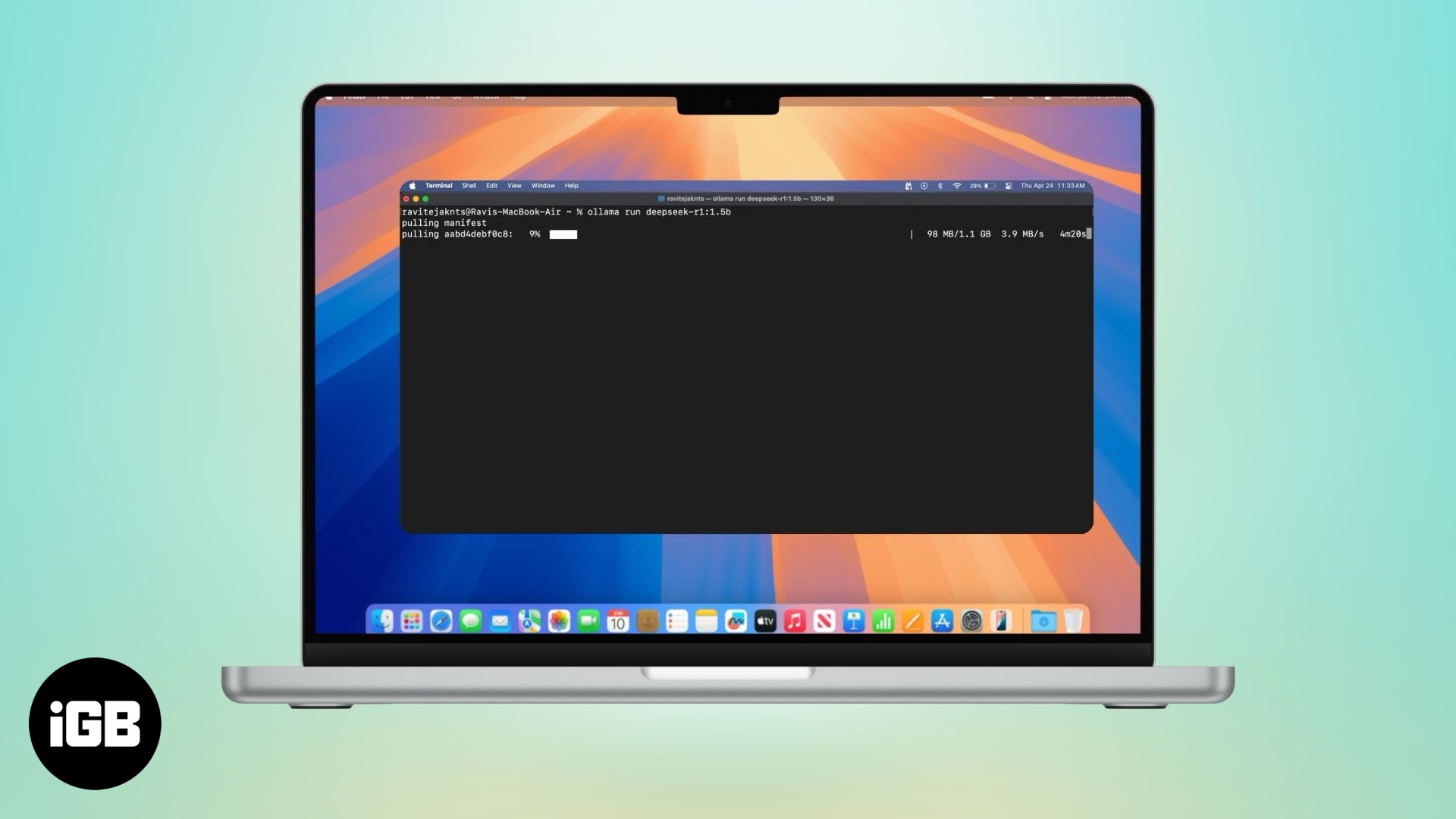

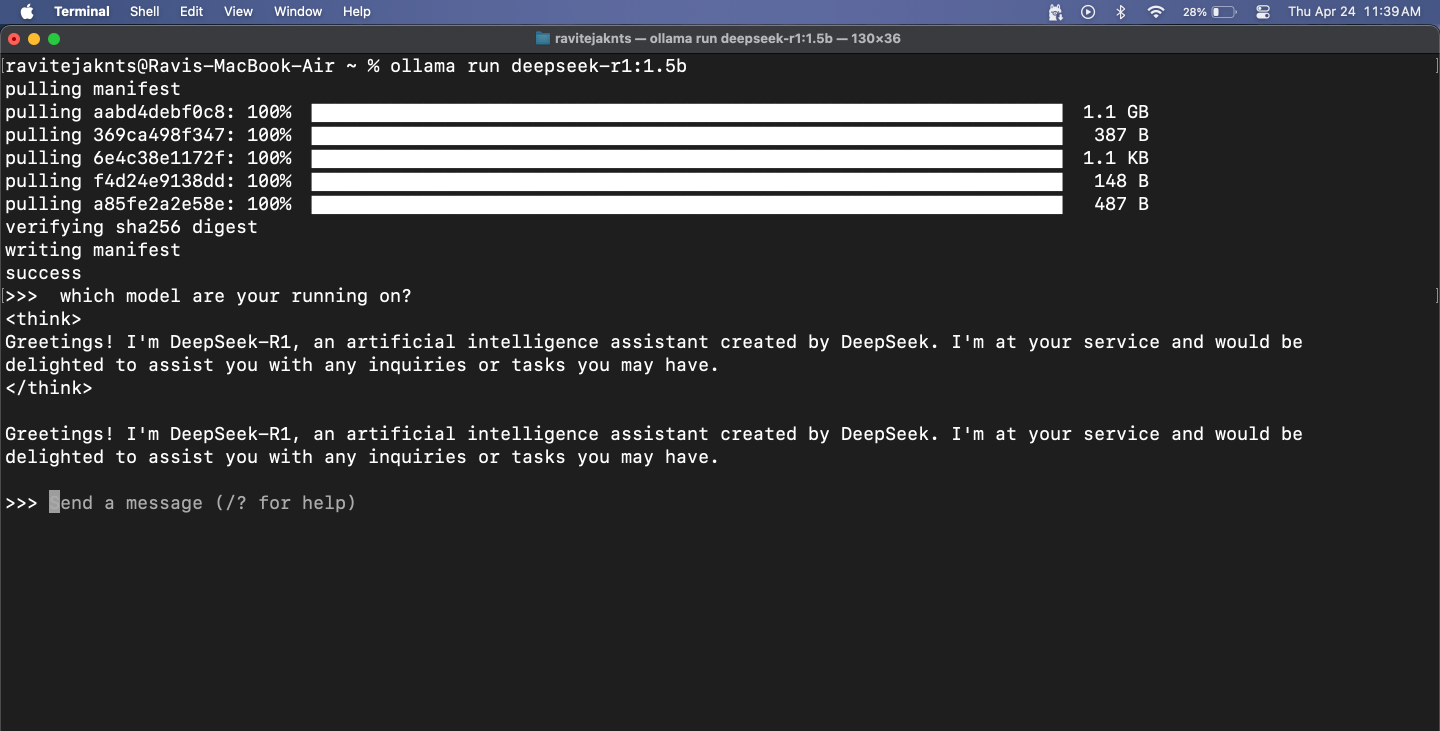

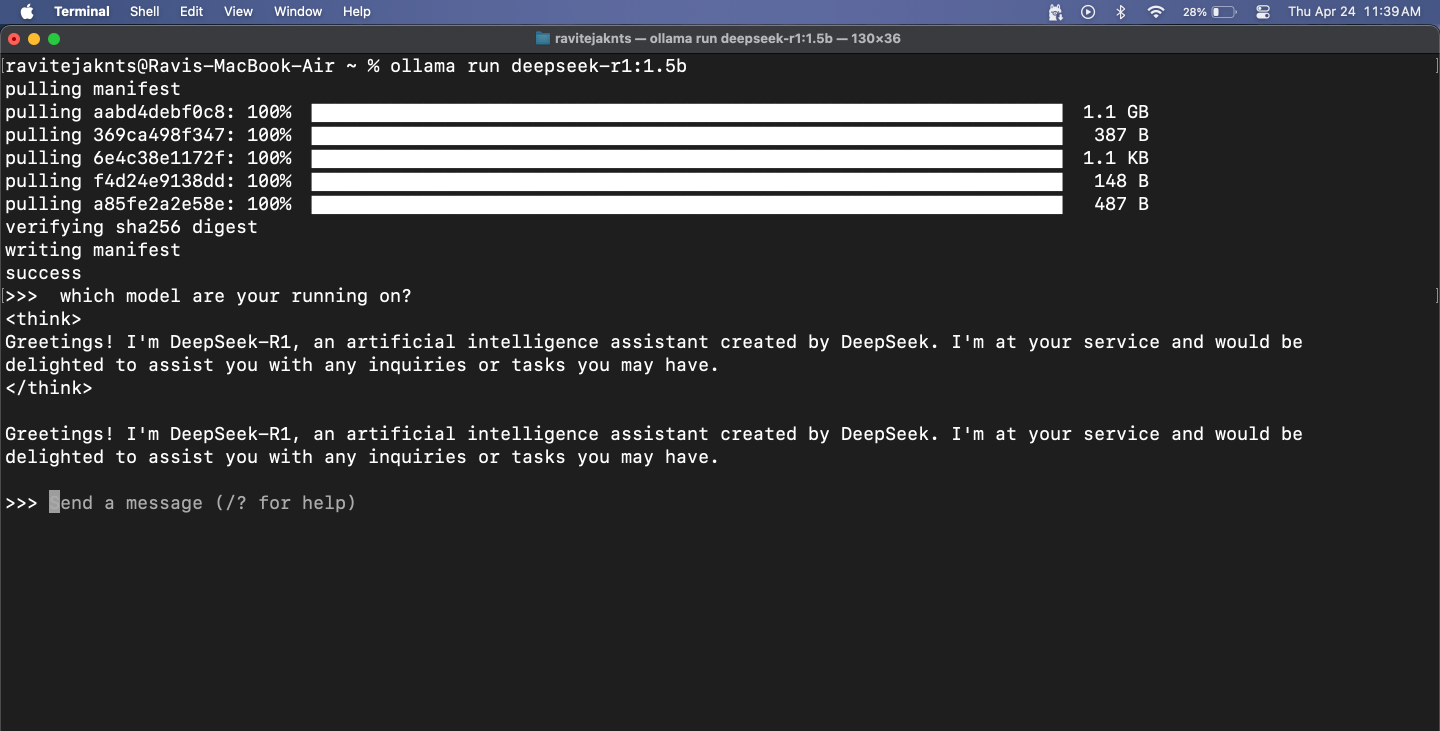

Adım 3: Bir Model İndirin ve Çalıştırın

Ollama size Deepseek, Meta's Lama, Mistral, Gemma ve daha fazlası gibi popüler LLM'lere erişmenizi sağlar. İşte birini nasıl seçip çalıştırabilirsiniz:

Büyük bir model seçerseniz, biraz gecikme bekleyin - sonra, tüm model Macbook'unuzda yerel olarak çalışıyor. Daha küçük modeller daha hızlı yanıt verir, ancak özellikle matematik ve mantıkla ilgili görevler için doğrulukla mücadele edebilirler. Ayrıca, bu modellerin İnternet erişimi olmadığından, gerçek zamanlı bilgi getiremeyeceklerini unutmayın.

Bununla birlikte, dilbilgisi kontrol etmek, e -posta yazmak veya fikirleri beyin fırtınası yapmak gibi şeyler için zekice çalışıyorlar. Deepseek-R1'i Macbook'umda bir web UI kurulumuyla yoğun bir şekilde kullandım, bu da resim yüklememe ve kod parçalarını yapıştırmama izin veriyor. Cevapları-ve özellikle kodlama becerileri-Chatgpt veya Deepseek 671B gibi üst düzey modeller kadar keskin olmasa da, hala en çok günlük görevleri internete ihtiyaç duymadan yapıyor.

4. Adım: Terminaldeki modelle sohbet edin

Model çalıştıktan sonra, mesajınızı yazabilir ve vurabilirsinizGeri dönmek. Model hemen aşağıda yanıt verecektir.

Oturumdan çıkmak için basınKontrol+Dklavyenizde. Tekrar sohbet etmeye başlamak istediğinizde, aynı şeyi kullanınollama run [model-name]emretmek. Model zaten indirildiğinden, anında başlayacak.

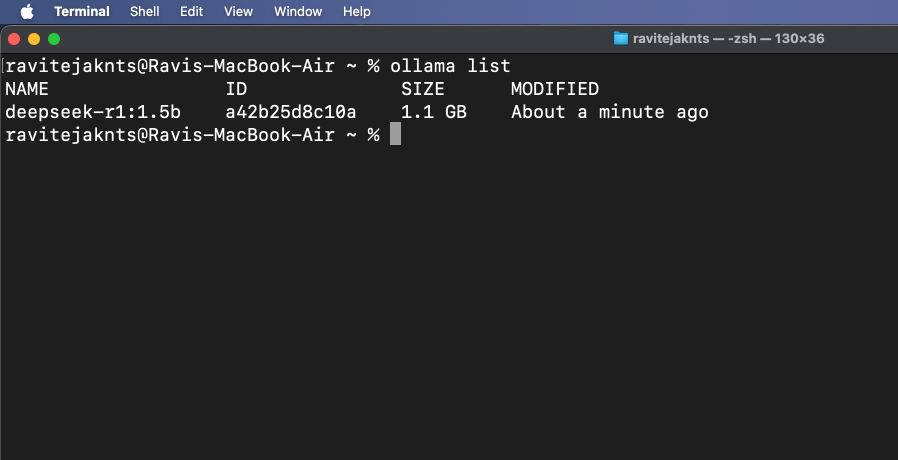

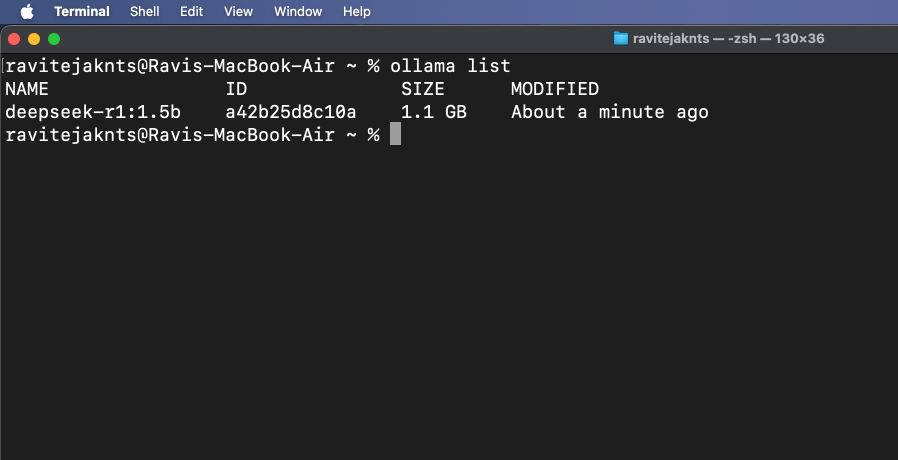

Adım 5: Yüklü Modelleri Görüntüle ve Yönetin

Şu anda hangi modellerin indirildiğini kontrol etmek için:

ollama list

Artık ihtiyacınız olmayan bir modeli silmek için:

ollama rm [model-name]Bonus: Web'de kullanıcı arayüzü ile Ollama kullanın

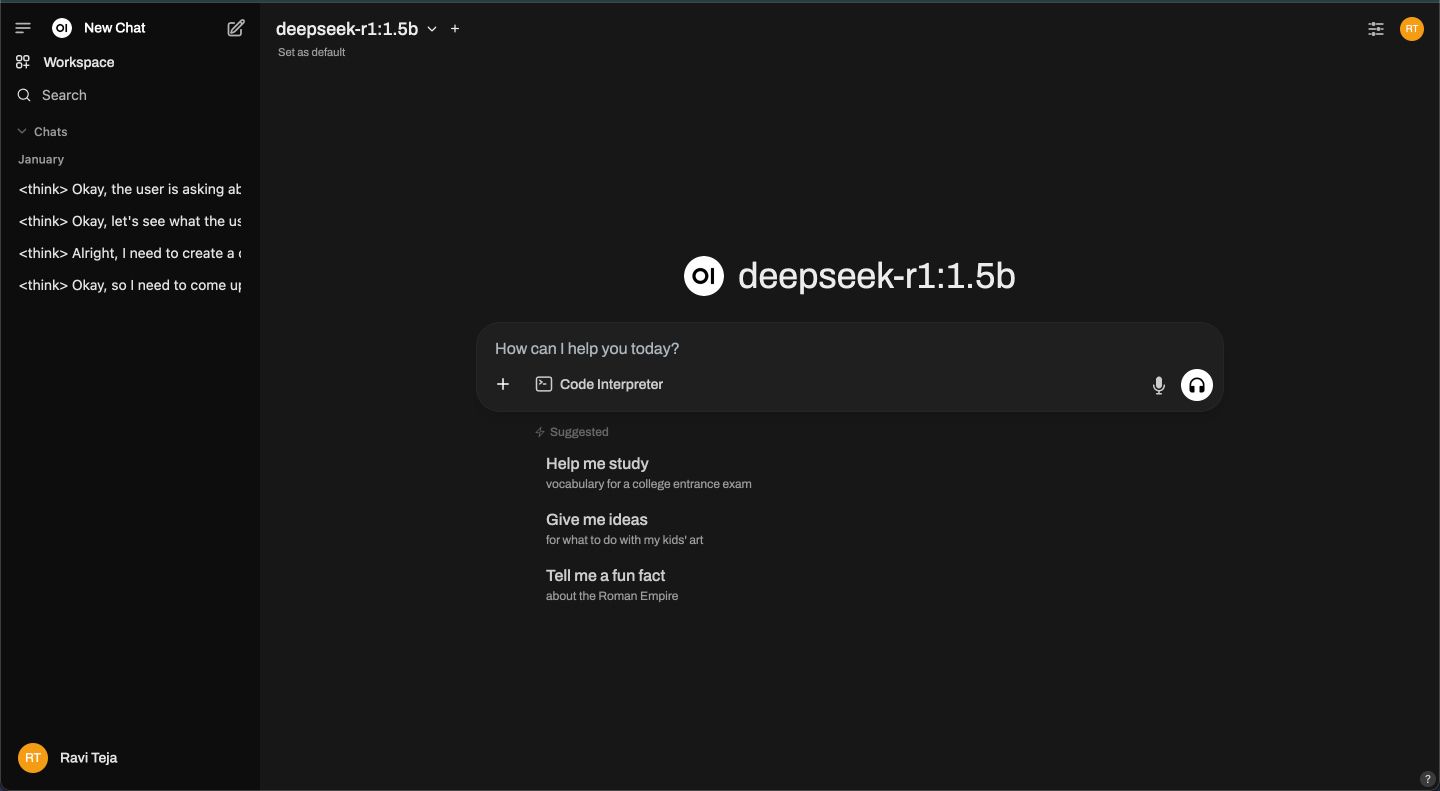

Ollama terminalde çalışırken, https: // localhost: 11434 adresinden yerel bir API hizmeti başlatarak, modellerle görsel etkileşim için bir web arayüzüne bağlamanıza izin verir - bir chatbot kullanmaya benzerdir. Bunun için popüler bir seçenek, Ollama'nın temel işlevselliğinin üstünde kullanıcı dostu bir arayüz sağlayan açık webui'dir. Bakalım nasıl kurulacağına bakalım.

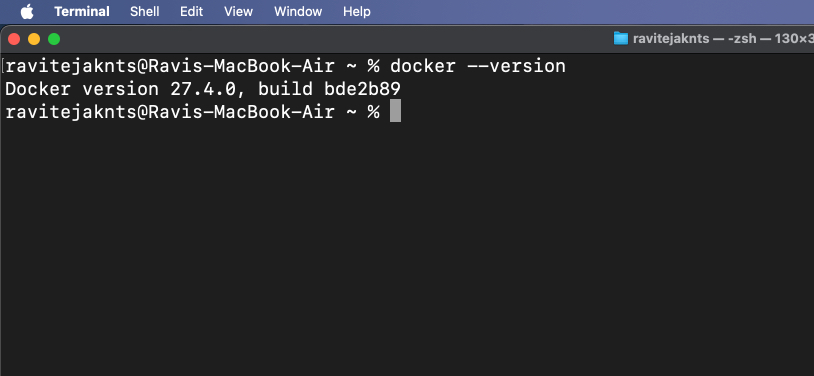

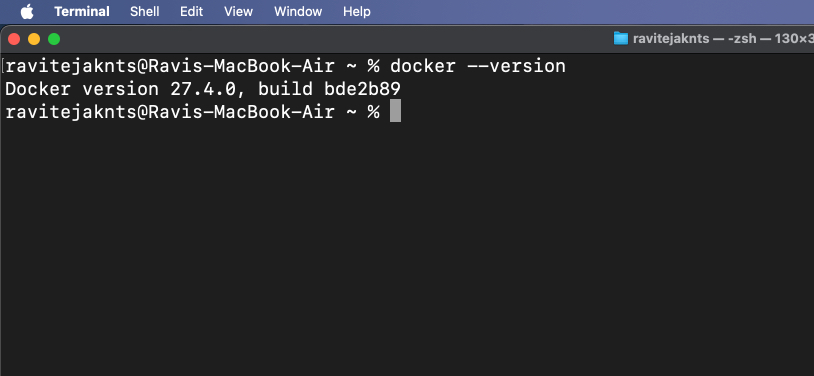

1. Adım: Docker'ı yükle

Docker, herhangi bir cihazda kolayca çalıştırabilmeniz için bir programı ve tüm temel öğelerini taşınabilir bir kapta paketlemenizi sağlayan bir araçtır. AI modeliniz için web tabanlı bir sohbet arayüzü açmak için kullanacağız.

Mac'iniz henüz sahip değilse, Docker'ı yüklemek için bu adımları izleyin:

docker --version

Komut bir sürüm numarası döndürürse, Docker'ın Mac'inize yüklü olduğu anlamına gelir.

2. Adım: Açık WebUI görüntüsünü çekin

Open Webui, tarayıcınızda size bir sohbet penceresi veren basit bir araçtır. Görüntüyü çekmek sadece çalıştırmak için gereken dosyaları indirmek anlamına gelir.

Bunu yapmak için,terminalUygulama ve Tür:

docker pull ghcr.io/open-webui/open-webui:mainBu, arayüz için gerekli dosyaları indirecektir.

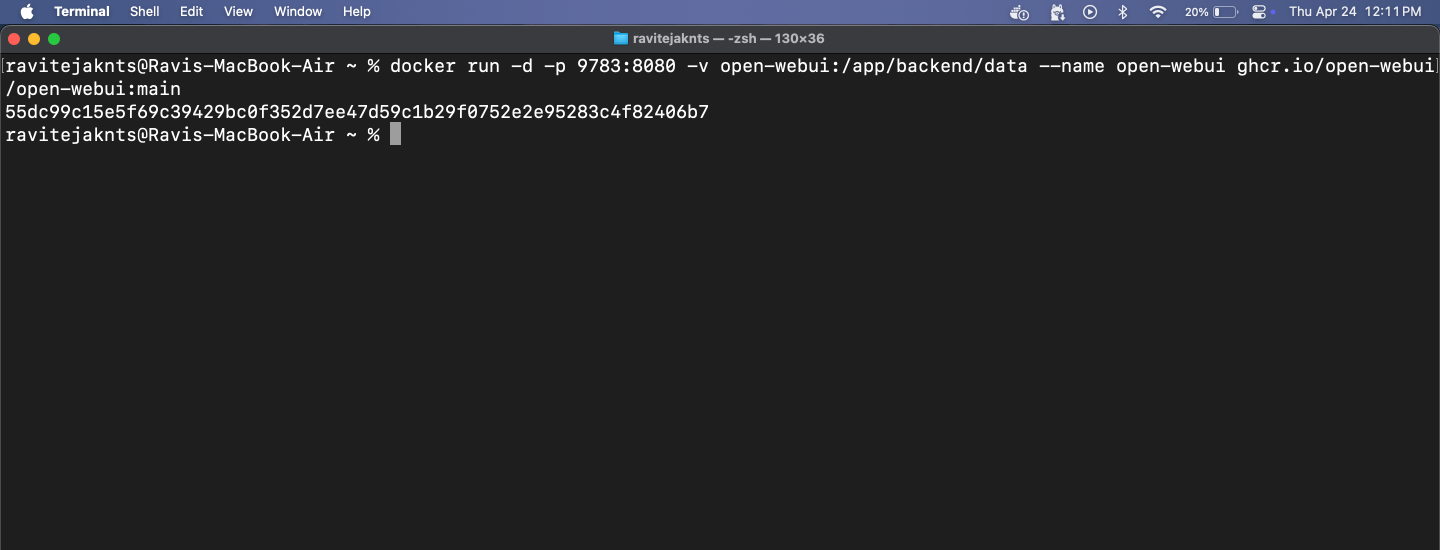

Adım 3: Docker Container'ı çalıştırın ve Webui'yi açın

Şimdi, Docker kullanarak açık webui çalıştırma zamanı. Yapay zekanızla sohbet edebileceğiniz temiz bir arayüz göreceksiniz - terminal gerekli değil. İşte yapmanız gerekenler:

docker run -d -p 9783:8080 -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main

https://localhost:9783/

İLGİLİ:Windows 11'de Dosya Explorer'ı yönetici olarak nasıl çalıştırılır

Buradan, yüklü herhangi bir modelle temiz, kullanıcı dostu bir tarayıcı arayüzünde sohbet edebilirsiniz. Bu adım isteğe bağlıdır, ancak terminali kullanmadan size daha pürüzsüz bir sohbet deneyimi sunar.

Mac'iniz, AI: Sunucu yok, dizeler yok

İşte bu! Sadece birkaç adımda, Mac'inizi tamamen çevrimdışı güçlü bir AI modelini çalıştırmak için kurdunuz. Kurulumdan sonra hesap yok, bulut yok ve internet gerekmiyor. İster özel sohbetler, ister yerel metin oluşturma veya sadece LLMS ile denemek isteyin, Ollama, geliştirici olmasanız bile kolay ve erişilebilir hale getirir. Bir deneyin!

Bu yararlı kılavuzlara da göz atın: